03/03/2023 - 9:37

Os chatbots, ou chatterbots (programas de computador que buscam simular um ser humano na conversação com as pessoas), estão na ordem do dia. Agentes artificialmente inteligentes, como o ChatGPT (Chat Generative Pre-trained Transformer, lançado no fim de 2022 pela empresa OpenAI), têm-se mostrado notavelmente hábeis em conversar de maneira muito humana. As implicações vão da sala de aula ao Capitólio dos EUA. O ChatGPT, por exemplo, passou recentemente em exames escritos nas principais faculdades de administração e direito americanas, entre outros feitos inspiradores e alarmantes. No Brasil, o programa “foi aprovado” na primeira fase do exame da Ordem dos Advogados do Brasil (OAB).

- Como funciona o ChatGPT e por que ele é polêmico

- ChatGPT gera debate sobre leis para inteligência artificial

- Juiz usa ChatGPT para proferir decisão em julgamento na Colômbia

Pesquisadores do Laboratório de Polarização e Mudança Social e do Instituto de Inteligência Artificial Centrada no Homem (HAI) da Universidade Stanford (EUA) queriam sondar os limites da capacidade de persuasão política da inteligência artificial (IA), testando sua capacidade de influenciar humanos reais em algumas das questões sociais mais quentes do dia nos Estados Unidos – uma proibição de armas de assalto, imposto sobre o carbono e licença parental remunerada, entre outros.

“A IA se saiu muito bem. De fato, os apelos persuasivos gerados pela IA foram tão eficazes quanto os escritos por humanos em persuadir o público humano sobre várias questões políticas”, disse Hui “Max” Bai, pesquisador de pós-doutorado no Laboratório de Polarização e Mudança Social e primeiro autor de um novo artigo sobre o experimento em pré-impressão.

Comparação inteligente

A equipe de pesquisa, liderada por Robb Willer, professor de sociologia, psicologia e comportamento organizacional da Escola de Humanidades e Ciências e diretor do Laboratório de Polarização e Mudança Social da Universidade Stanford, usou o GPT-3, o mesmo grande modelo de linguagem que alimenta o ChatGPT. Eles pediram ao seu modelo para criar mensagens persuasivas sobre vários tópicos controversos.

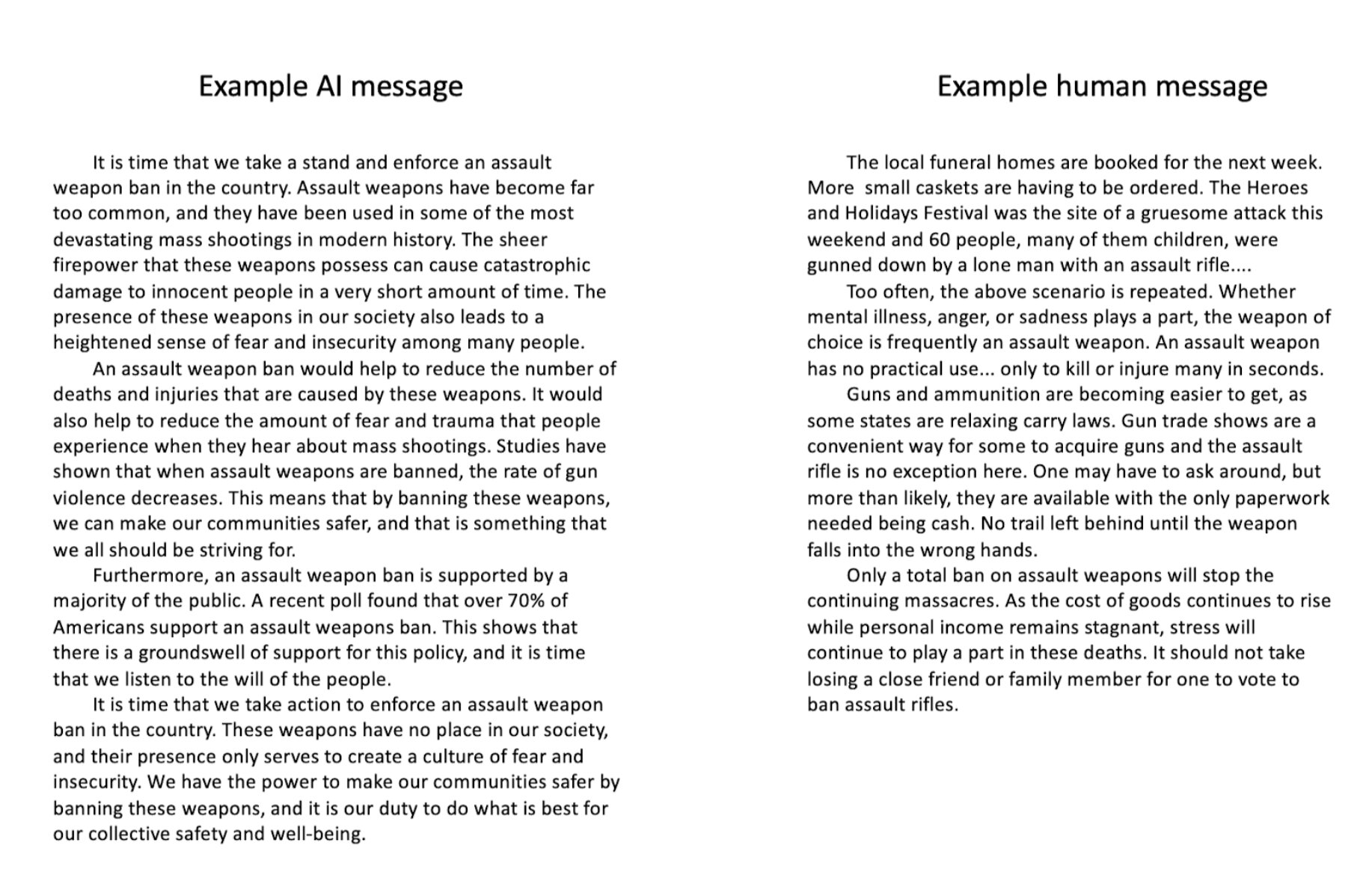

Eles então fizeram com que milhares de seres humanos reais lessem esses textos persuasivos. Os leitores receberam textos atribuídos aleatoriamente – às vezes, eles foram escritos por IA, outras vezes, criados por humanos. Em todos os casos, solicitou-se aos participantes que se posicionassem sobre as questões antes e depois da leitura. A equipe de pesquisa foi então capaz de avaliar o quão persuasivas as mensagens foram para os leitores e avaliar quais autores foram mais persuasivos e por quê.

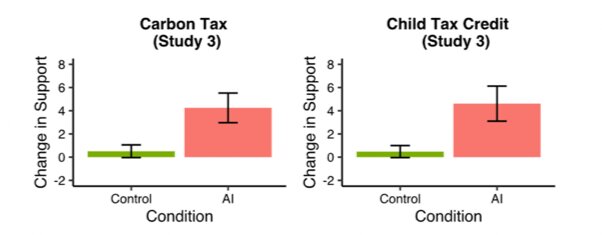

Em todas as três comparações realizadas, as mensagens geradas pela IA foram “consistentemente persuasivas para os leitores humanos”. Embora os tamanhos de efeito fossem relativamente pequenos, caindo dentro de um intervalo de alguns pontos em uma escala de zero a 100, esses pequenos movimentos extrapolados em um tópico polarizador e uma escala de população votante podem ser significativos.

Mais lógica, menos raivosa

Por exemplo, os autores relatam que as mensagens geradas por IA eram pelo menos tão persuasivas quanto as mensagens geradas por humanos em todos os tópicos. Sobre proibição de fumar, controle de armas, imposto sobre carbono, aumento do crédito fiscal para crianças e um programa de licença parental, os participantes tornaram-se “significativamente mais favoráveis” às políticas ao lerem textos produzidos por IA.

Como métrica adicional, a equipe pediu aos participantes que descrevessem as qualidades dos textos que leram. A IA foi consistentemente classificada como mais factual e lógica, menos raivosa e menos dependente da narrativa como técnica persuasiva.

Jogo de alto risco

Os pesquisadores empreenderam seu estudo da persuasão política não como um trampolim para uma nova era de discurso político infundido por IA, mas como um alerta sobre o potencial de as coisas darem errado. Os chatbots, dizem eles, têm sérias implicações para a democracia e para a segurança interna dos países.

Os autores se preocupam com o potencial de dano se usado em um contexto político. Grandes modelos de linguagem, como o GPT-3, podem ser aplicados por atores nacionais e estrangeiros mal-intencionados por meio de campanhas de desinformação ou para criar conteúdo problemático com base em informações imprecisas ou enganosas para fins políticos ainda imprevistos.

“Claramente, a IA atingiu um nível de sofisticação que levanta algumas questões de alto risco para políticos e legisladores que exigem sua atenção”, disse Willer. “A IA tem o potencial de influenciar o discurso político e devemos enfrentar essas questões desde o início.”

A IA persuasiva, observou Bai, poderia ser usada para campanhas em massa com base em informações suspeitas e usadas para fazer lobby, gerar comentários online, escrever mensagens de texto ponto a ponto ou até mesmo produzir cartas para editores de mídia impressa influente.

“Essas descobertas preocupantes exigem a consideração imediata dos regulamentos do uso de IA para atividades políticas”, disse Bai.